Saat melakukan optimasi SEO (Search Engine Optimization) pada sebuah website, keberadaan file Robots.txt adalah salah satu yang harus kamu perhatikan. Pasalnya, file ini berhubungan langsung dengan mesin pencari yang akan mengindeks website.

Bagi kamu yang terbilang masih baru mempelajari SEO secara teknis, maka kamu pastinya ingin mempelajarinya lebih detail. Pada artikel kali ini, kami akan mengajak kamu berkenalan dengan Robots.txt yang berperang penting di SEO. Langsung saja, yuk simak lebih dalam!

Daftar isi

Apa Itu Robots.txt?

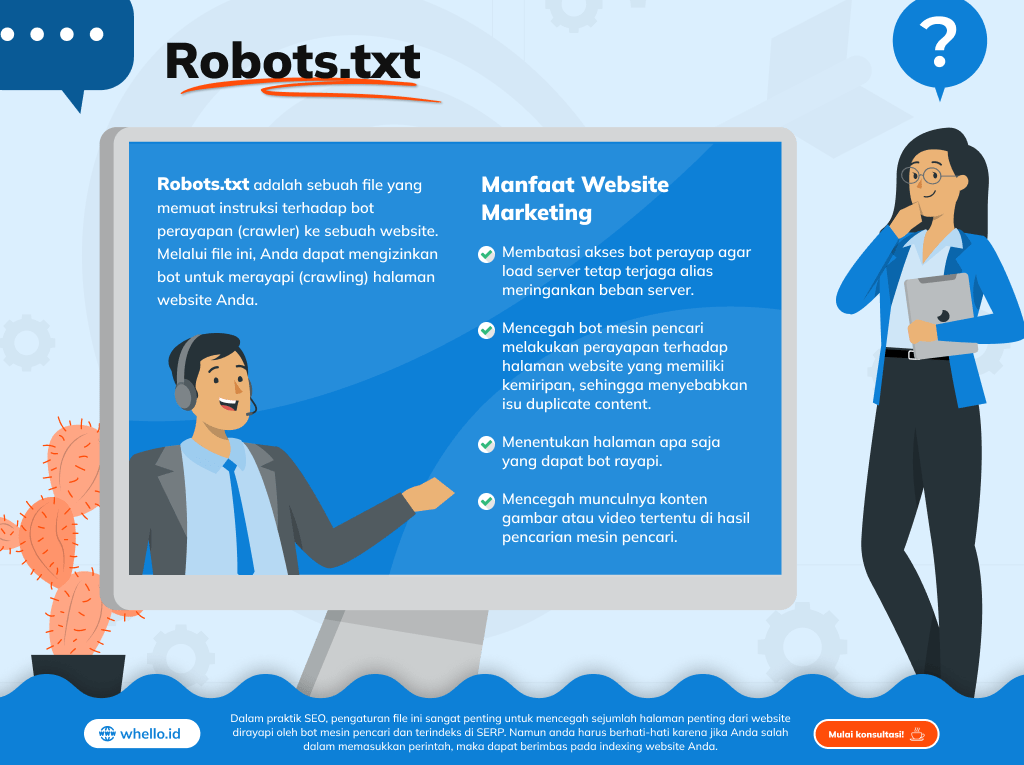

Singkatnya, Robots.txt adalah sebuah file yang memuat instruksi terhadap bot perayapan (crawler) ke sebuah website. Melalui file ini, kamu dapat mengizinkan bot untuk merayapi (crawling) halaman website kamu.

File ini biasanya diletakkan pada bagian direktori root website dan dapat kamu akses melalui alamat format alamat URL “nama domain kamu/robots.txt”. Namun, file ini bukan menjadi cara yang ampuh untuk menyembunyikan informasi tertentu di halaman website kamu.

Pasalnya, file ini hanya mengatur akses bot, termasuk bot mesin pencari. Jadi, jika pengunjung mengetahui URL dari halaman yang kamu tidak izinkan untuk terindeks, maka mereka tetap dapat mengakses halaman tersebut.

Dalam website audit, memahami fungsi dan cara membuat Robots.txt adalah hal yang wajib kamu pahami. Pasalnya, tidak jarang muncul isu SEO yang melibatkan file ini.

Fungsi Robots.txt

Seperti yang dijelaskan sebelumnya, fungsi utama Robots.txt adalah mengatur instruksi untuk bot mesin pencari yang melakukan perayapan pada website. Namun, file ini juga memiliki beberapa fungsi lainnya. Adapun beberapa fungsi yang dimaksud adalah sebagai berikut:

- Membatasi akses bot perayap agar load server tetap terjaga alias meringankan beban server.

- Mencegah bot mesin pencari melakukan perayapan terhadap halaman website yang memiliki kemiripan, sehingga menyebabkan isu duplicate content.

- Menentukan halaman apa saja yang dapat bot rayapi.

- Mencegah munculnya konten gambar atau video tertentu di hasil pencarian mesin pencari.

Cara Membuat Robots.txt

Setelah memahami tentang definisi dan fungsi dari Robots.txt, mari bahas tentang cara membuat file ini. Namun, sebelum masuk ke bagian ini, terdapat beberapa istilah yang sebaiknya kamu pahami. Adapun beberapa istilah tersebut meliputi:

- User Agent: Instruksi berbentuk script yang berfungsi untuk mendeskripsi bot yang mana yang diizinkan untuk merayapi website kamu. Adapun contoh dari user agent adalah Googlebot.

- Allow: Instruksi yang mengizinkan user agent untuk melakukan perayapan terhadap website kamu.

- Disallow: Instruksi yang tidak mengizinkan user agent untuk melakukan perayapan terhadap website kamu.

- Sitemap: Instruksi yang menginformasikan lokasi sitemap website kamu, sehingga user agent dapat merayapinya. Dalam SEO sendiri, membuat sitemap sendiri termasuk salah satu cara agar website terindex Google dengan cepat.

Langkah-Langkah Membuat Robots.txt

Berikut panduan cara membuat file Robots.txt:

1. Buat file teks kosong dengan nama “robots.txt” menggunakan teks editor biasa, seperti Notepad atau Visual Studio Code.

2. Tentukan aturan-aturan yang sesuai dengan kebutuhan kamu. Misalnya, jika kamu ingin mengizinkan Google untuk crawl seluruh data website, maka kamu dapat menggunakan:

User-agent: Google

Allow : /

Disallow: /

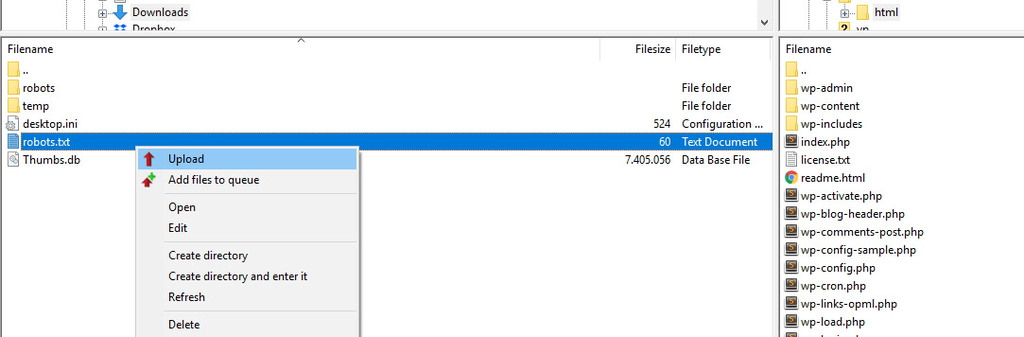

3. Setelah menentukan semua direktif dan aturan yang diinginkan, simpan file robots.txt tersebut dalam direktori root website kamu. Direktori root biasanya adalah direktori utama di mana berkas-berkas website disimpan.

4. Lalu, kamu bisa langsung upload file tersebut ke folder website. Dalam hal ini, kamu dapat melakukannya dengan FTP (File Transfer Protocol). Setelah file berhasil terupload, kamu dapat memeriksa file tersebut melalui format URL “nama domain kamu/Robots.txt” di browser.

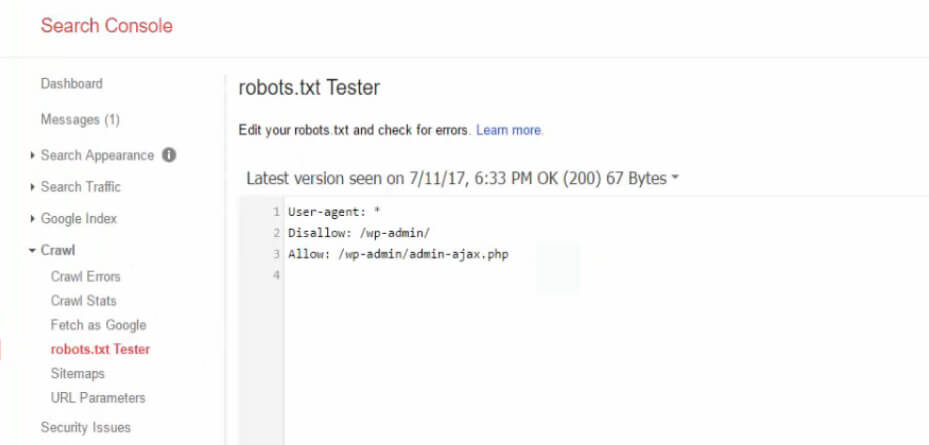

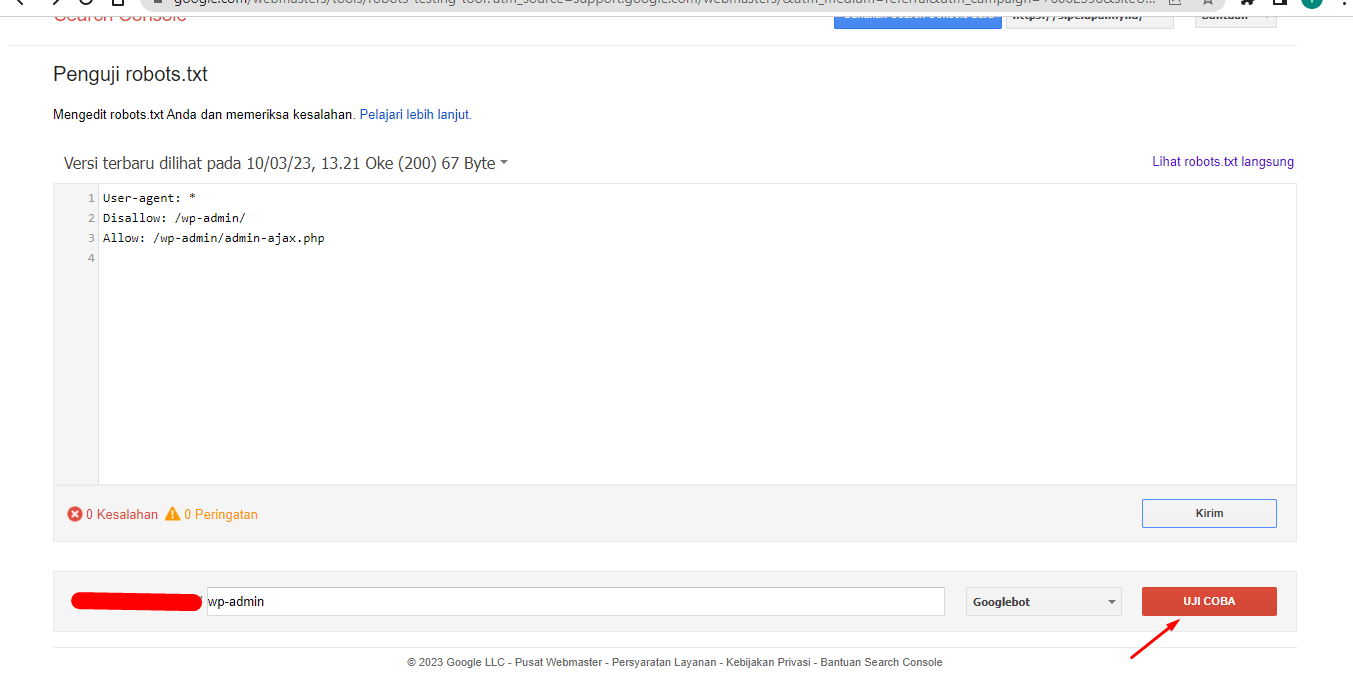

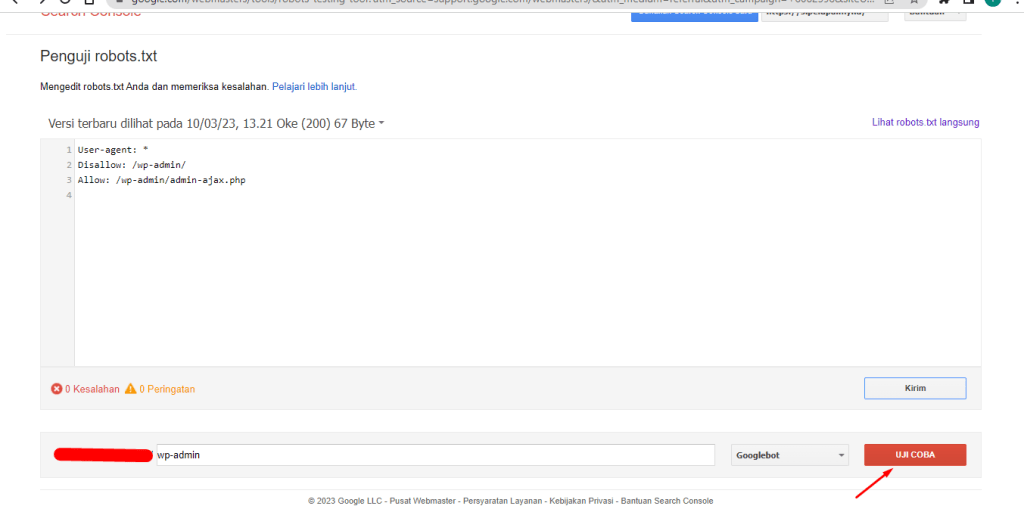

5. Untuk memastikan bahwa file robots.txt berfungsi dengan baik, kamu dapat menggunakan alat verifikasi robot yang disediakan oleh mesin pencari seperti Google Search Console atau alat online lainnya. Ini akan membantu memeriksa apakah file tersebut ditulis dengan benar dan menghasilkan hasil yang diinginkan.

Jika kamu ingin mengeceknya di GSC, silahkan login terlebih dahulu di akun GSC dan pilih website yang ingin diuji. Lalu klik tombol Uji Coba yang berada di kanan bawah. Apabila instruksi sudah sesuai dan berjalan lancar, maka Robots.txt yang kamu buat sudah benar.

6. Setelah kamu yakin bahwa file robots.txt berfungsi seperti yang diinginkan, pastikan untuk mempublikasikannya di web server kamu. Pastikan juga untuk memeriksa kembali dan memperbarui file tersebut jika ada perubahan pada struktur situs atau aturan akses yang ingin diterapkan.

Cara Cek Robots.txt dari Google Search Console

Setelah mengupload file Robots.txt, hal selanjutnya yang perlu kamu lakukan adalah melakukan uji coba script melalui tool Google Search Console (GSC). Untuk bagian ini, kamu dapat login ke akun GSC yang terhubung dengan website kamu.

Jika kamu belum menambahkan website kamu ke Google Search Console, maka kamu dapat mendaftarkannya terlebih dahulu. Selanjutnya, kamu dapat mengakses robots testing tools dan memilih website yang ingin kamu uji.

Untuk lebih singkatnya, kamu dapat langsung mengunjungi anchor text yang kami berikan sebelumnya. Jika file bot telah muncul, maka kamu dapat menekan tombol “Uji Coba” yang tersedia untuk memulai pengujian file.

Setelahnya, kamu dapat melihat hasil uji coba tersebut di bagian bawah. Jika hasilnya sesuai dengan instruksi yang terdapat di file Robots.txt kamu, maka file tersebut telah berjalan sesuai dengan fungsinya.

Selain dengan menggunakan robots testing tools, sebenarnya kamu juga dapat menguji file ini dengan memanfaatkan online tools gratis lainnya. Adapun beberapa tools gratis yang kami maksud tersebut adalah seperti SEO Site Checkup, Website Planet, dan technicalseo.com.

Robots.txt vs Meta Tag, Apa Perbedaannya?

Hingga hari ini masih banyak blogger pemula yang salah kaprah menganggap bahwa meta tag dan Robots.txt adalah hal yang sama. Jika dilihat sekilas, keduanya memang memiliki fungsi yang sama, yaitu memberikan sinyal kepada mesin pencari tentang mana saja halaman yang dapat dirayapi dan yang tidak.

Adapun contoh dari meta tag sendiri adalah “noindex”, “follow”, dan “nofollow”. Meskipun fungsinya mirip, namun keduanya memiliki perbedaan yang sangat mendasar.

Melansir dari laman Search Engine Journal, Robots.txt memiliki fungsi untuk memberikan perintah kepada bot perayap terkait perayapan seluruh halaman website. Sedangkan, meta tag dalam hal ini hanya berfokus untuk memberikan instruksi untuk salah satu halaman spesifik saja.

Selain itu, seiring dengan perkembangan dunia SEO saat ini, meta tag dapat kamu atur dengan mudah melalui sejumlah plugin SEO, seperti Rank Math dan Yoast SEO. Namun, untuk file bot ini, kamu harus mengaplikasikannya secara manual. Dengan kata lain, kamu harus cukup fasih dengan HTML dan juga database.

Sudah Lebih Paham dengan Konsep Robots.txt?

Kesimpulannya, Robots.txt adalah sebuah file berisi instruksi untuk bot perayap ke sebuah website. Instruksi ini menentukan apakah bot dapat merayapi semua halaman website atau hanya beberapa saja.

Dalam praktik SEO, pengaturan file ini sangat penting untuk mencegah sejumlah halaman penting dari website dirayapi oleh bot mesin pencari dan terindeks di SERP. Namun, dalam setting file ini, kamu harus berhati-hati karena jika kamu salah dalam memasukkan perintah, maka dapat berimbas pada indexing website.

Untuk itu, jika kamu belum terlalu memahami hal ini, maka kamu perlu berkonsultasi terlebih dahulu dengan jasa SEO berpengalaman, seperti Whello. Jasa SEO ini menyediakan layanan dan konsultasi SEO yang dapat membantu optimasi visibilitas website kamu, termasuk penyesuaian Robot.txt ini.

Robot TXT untuk apa?

File Robots.txt memiliki fungsi untuk memberi sinyal kepada bot perayap mesin pencari terkait mana saja halaman di website yang dapat dirayapi.

Apa singkatan dari txt?

Txt adalah singkatan dari text.

Apa yang dimaksud dengan robots txt pada web scraping?

Robots.txt adalah file yang berisi perintah spesifik kepada bot yang melakukan perayapan ke sebuah website.

Apa tujuan Web Scraping?

Web scraping adalah teknik pengumpulan data dalam jumlah besar dari suatu website yang nantinya akan dipergunakan untuk keperluan riset, analisa, dan lain sebagainya.

Mulai optimasi SEO website bisnismu sekarang!

Dapatkan posisi page 1 Google dan tingkatkan traffic serta revenue pada website bisnis kamu dengan SEO. Konsultasi dengan specialist kami sekarang!

Mulai Konsultasi!Ingin konsultasi

dengan para specialist

Whello?

Tips lainnya dari kami

Jangan Panik! Begini Cara Mengembalikan Akun Instagram yang Kena Hack

Bingung cara mengembalikan akun Instagram yang di-hack? Tenang, kami punya panduan lengkap untuk membantu mengatasi masalah ini dengan cepat!

Penasaran Siapa yang Unfollow Kamu? Begini Cara Ceknya!

Penasaran cara cek siapa unfollow instagram kamu? Ini dia tools yang dapat digunakan untuk mengecek followers kamu!

Panduan Lengkap Cara Hapus Ulasan di Google Maps

Salah membuat ulasan di google maps atau mau hapus ulasan tidak relevan atau mengandung SARA? Ini dia cara hapus ulasan di google maps!

Follow us on Instagram

Temukan tips bermanfaat digital marketing serta keseruan spesialis Whello dalam menumbuhkan brand, hanya di Instagram @whello.indonesia. Follow, ya!